https://youngmany.tistory.com/7

이전 포스팅에서 ELK 설치 후 웹 브라우저 접근까지 완료하였습니다.

이번 포스팅에서는 Remote 장비에 Filebeat를 설치하여 로그를 수집해보겠습니다.

구조

위 그림과 같이 Ovirt Cluster로 구성된 각 노드에 Filebeat를 설치하여 로그를 수집해보겠습니다.

FileBeat 설치

제가 FileBeats를 설치하는 OS는 CentOS 7.X이며, Filebeat 버전은 이전 포스팅에서 설치한 ELK Stack과 버전을 맞춰 설치하겠습니다.

저는 아래의 공식 사이트에서 RPM으로 설치하였습니다.

https://www.elastic.co/guide/en/beats/filebeat/current/filebeat-installation.html

Step 1: Install Filebeat | Filebeat Reference [7.2] | Elastic

If script execution is disabled on your system, you need to set the execution policy for the current session to allow the script to run. For example: PowerShell.exe -ExecutionPolicy UnRestricted -File .\install-service-filebeat.ps1.

www.elastic.co

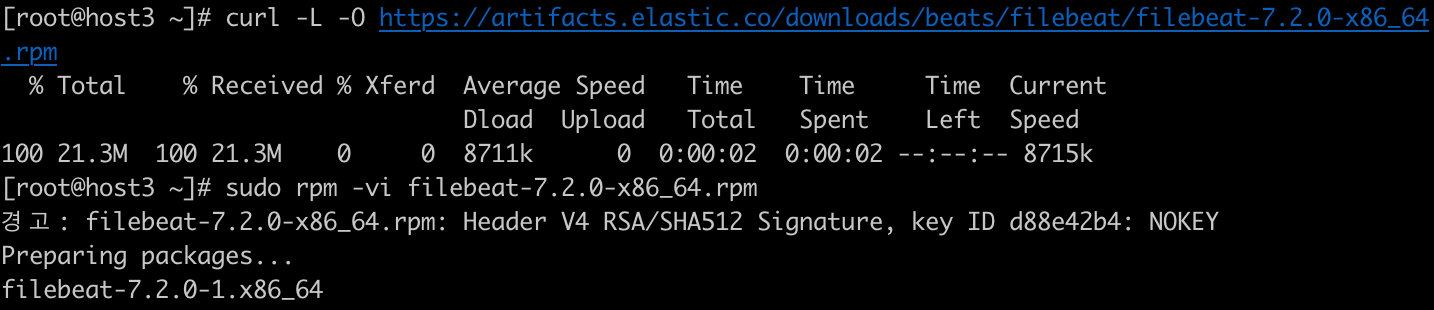

SSH로 설치 할 노드에 접근하여서..

아래의 명령어를 입력하여 설치하였습니다.

이러면 Filebeat 설치가 완료된 것입니다.

웹 사이트 여러 자료를 찾아보면 로컬 머신의 filebeat 설정 파일을 수정하여 사용하는데 저는 Elastic의 신 기능(?)을 사용하여 Filebeat를 손쉽게 연동해보겠습니다.

Cenrtal Management를 사용하여 Beats 붙이기

저번 포스팅에 설치 한 Kibana에 접근하셔서 맨 아래 Management에 접근하시면 여러 목록이 나옵니다.

그중 Beats의 Central Management로 접근해줍니다.

접근하시면, 저는 미리 하나 노드를 연결해놔서 아래와 같은 화면이 나오는 것이고, 현재 아무것도 없으신 상태이실 겁니다. 당황하지 마시고 Enroll Beats를 눌러주시면 됩니다.

접근하시면, 아래와 같은 화면이 생성이 될텐데, 여기서 밑에 Copy command를 누르시고,

Filebeat를 설치하셨던 원격 노드에 해당 명령어를 실행하시면 됩니다.

명령어를 실행시키시면, 아래와 같은 화면이 나오실겁니다. Done을 누르시면 됩니다.

맨 처음 설치하면 마법사 형태로 바로 Create tag로 넘어가서 설정을 진행할 텐데, 두 번째 설치 상태에서 해당 포스팅을 작성하고 있어, 화면을 캡처해드릴 수 없네요ㅠㅠ.. 저는 Add Configuration blocks 설정을 아래와 같이 추가하였습니다.

Filebeat Input으로 수집 하실 로그 파일 이름을 paths에 작성해주시면 됩니다. 저는 우선 아래와 같이 작성하였습니다. (저는 ovirt 로그를 수집할 예정이라 아래와 같이 작성한 것이고 syslog 같은 로그로 테스트하시면 됩니다.)

그다음, 수집한 데이터를 logstash로 보내도록 output을 아래와 같이 설정하였습니다.

이렇게 설정하시고 다음으로 넘어가시고 Finish까지 완료하시면 FileBeats 설정이 끝났습니다.

Management에 Index Management로 접근하시면 아래와 같이 로그 데이터가 쌓이는 걸 확인하실 수 있습니다.

이제 쌓은 로그를 kibana로 볼 수 있도록 index patterns을 설정해줍니다.

Creae index pattern을 누르시면 됩니다.

Index pattern에 Index management에서 확인하셨던 내용을 입력해줍니다

아래와 같이 추가 설정하시고, Create index pattern을 누르시면

아래와 같은 화면이 나올 것 입니다.

왼쪽 탭 맨 위 Discover로 접근하시면 아래와 같이 로그 데이터가 쌓이는 것을 확인하실 수 있습니다.

ELK Stack을 설치하고, Remote 장비에 Filebeat를 설치하여 로그를 수집하는 것까지 완료하였습니다.

하지만 위와 같은 로그 형태는 실질적으로 모니터링하고, 분석하기 적합하지 않은 데이터인 것 같습니다.

다음 포스팅에서는 logstash filter를 활용하여 고도화 작업을 진행해보도록 하겠습니다!

'ELK' 카테고리의 다른 글

| Docker-compose를 사용하여 Elastic Stack 7.2를 구축하고 FileBeat를 사용하여 모니터링 하기 - 1 (0) | 2019.07.02 |

|---|